Transparenz: Um diesen Blog kostenlos anbieten zu können, nutzen wir Affiliate-Links. Klickst du darauf und kaufst etwas, bekommen wir eine kleine Vergütung. Der Preis bleibt für dich gleich. Win-Win!

Wenn die eigene Stimme zur Waffe wird: Der Aufstieg von KI-gestütztem Audio-Betrug

Lange Zeit waren Phishing-Mails mit schlechter Grammatik das Hauptwerkzeug von Cyberkriminellen. Doch mit dem rasanten Fortschritt der generativen Künstlichen Intelligenz (KI) hat sich das Bedrohungspotenzial dramatisch gewandelt. Heute reicht ein kurzer Audio-Schnipsel aus, um die Stimme eines normalen Menschen täuschend echt zu klonen.

Das Phänomen, bekannt als „Voice Cloning“ oder „Deepfake Audio“, revolutioniert Betrugsmaschen wie den klassischen Enkeltrick.

Themenübersicht

- Leica Leitzphone (2026): Der neue Maßstab für Smartphone-Fotografie? 1. März 2026

- Amazon deckt auf: KI macht Anfänger zum Super-Hacker 27. Februar 2026

- KI auf Knopfdruck weg: Das ist neu in Firefox 148 26. Februar 2026

- WhatsApp Premium 2026: Kommt jetzt das Bezahl-Abo für alle? 26. Februar 2026

- Kein Plagiat: Die besten KI-Tools für Studierende 26. Februar 2026

Die Technologie: Drei Sekunden reichen aus

Früher benötigten Software-Programme stundenlanges Audiomaterial, um eine synthetische Stimme zu erstellen. Moderne KI-Modelle haben diese Barriere durchbrochen. Microsofts VALL-E oder kommerzielle Tools von Start-ups (die eigentlich für Synchronisation oder Hörbücher gedacht sind) können Stimmen mittlerweile mit einer Audio-Vorlage von nur drei Sekunden überzeugend imitieren.

Die KI analysiert dabei nicht nur die Tonhöhe, sondern auch den Sprachrhythmus, die Betonung und sogar emotionale Nuancen. Das Ergebnis ist eine synthetische Stimme, die Sätze sagen kann, die die echte Person nie gesprochen hat.

Woher die Betrüger Ihre Stimme haben

Kriminelle müssen keine komplexen Hacks durchführen, um an das nötige Stimmmaterial zu gelangen. Die Quellen sind oft öffentlich zugänglich:

Soziale Medien: Dies ist die ergiebigste Quelle. Ein kurzes Video in der Instagram-Story, ein TikTok-Clip oder ein Facebook-Urlaubsvideo, in dem man spricht, liefert oft ausreichendes Material.

Anrufbeantworter: Die persönliche Ansage auf der Mailbox ist oft eine saubere, rauschfreie Aufnahme der eigenen Stimme.

Spam-Anrufe: Kriminelle rufen unter Vorwänden an (z. B. falsche Umfragen), um das Opfer in ein Gespräch zu verwickeln und die Stimme aufzuzeichnen.

Der Fall Jennifer DeStefano: Ein prominentes Beispiel aus den USA verdeutlicht die Gefahr. Jennifer DeStefano erhielt einen Anruf, in dem sie ihre 15-jährige Tochter weinen und schreien hörte, gefolgt von der Stimme eines Mannes, der Lösegeld forderte. Die Stimme der Tochter war ein KI-Klon. Die echte Tochter war sicher auf einem Skiausflug.

Die Betrugsszenarien

Sobald die Stimme geklont ist, wird sie für verschiedene Betrugsarten eingesetzt:

1. Der Enkeltrick 2.0 (Shock Calls)

Der klassische Enkeltrick basierte darauf, dass das Opfer aufgrund schlechter Verbindungsqualität oder Nuscheln glaubte, den Verwandten zu hören. Mit KI klingt der Anrufer nun exakt wie der Enkel, das Kind oder der Partner. Die Geschichten sind dramatisch: Ein Autounfall, eine Festnahme oder eine Entführung. Der Schockmoment und die vertraute Stimme schalten das rationale Denken des Opfers aus.

2. Umgehung von Sicherheitsbarrieren

Einige Banken und Dienstleister nutzen „Voice ID“ zur Authentifizierung am Telefon. Sicherheitsforscher haben bereits demonstriert, dass KI-generierte Stimmen diese biometrischen Sicherheitsschleusen überwinden können.

3. CEO-Fraud (Betrug im geschäftlichen Umfeld)

Hierbei werden Mitarbeiter der Buchhaltung von der vermeintlichen Stimme ihres Chefs angerufen und angewiesen, dringende Überweisungen auf fremde Konten zu tätigen. Ein spektakulärer Fall ereignete sich bereits 2019, als der CEO eines britischen Energieunternehmens durch eine KI-Stimme um 220.000 Euro betrogen wurde.

Statistiken und Risikowahrnehmung

Eine Studie von McAfee („The Artificial Imposter“, 2023) lieferte schon zu diesem Zeitpunkt alarmierende Zahlen:

- 53 % der Erwachsenen, die an der Studie teilnahmen, gaben an, dass sie ihre eigene Stimme online geteilt haben (durch Social Media etc.).

- 70 % der Befragten waren nicht sicher, ob sie eine KI-Stimme von einer echten Stimme unterscheiden könnten.

- Weltweit gab einer von vier Befragten an, bereits Erfahrungen mit KI-Stimmenbetrug gemacht zu haben (selbst betroffen oder im Bekanntenkreis).

Auch die Federal Trade Commission (FTC) in den USA warnt explizit vor dem Anstieg dieser Betrugsmasche und berichtet von jährlichen Schäden in Millionenhöhe durch „Imposter Scams“.

Wie man sich schützt

Experten und Behörden empfehlen folgende Schutzmaßnahmen:

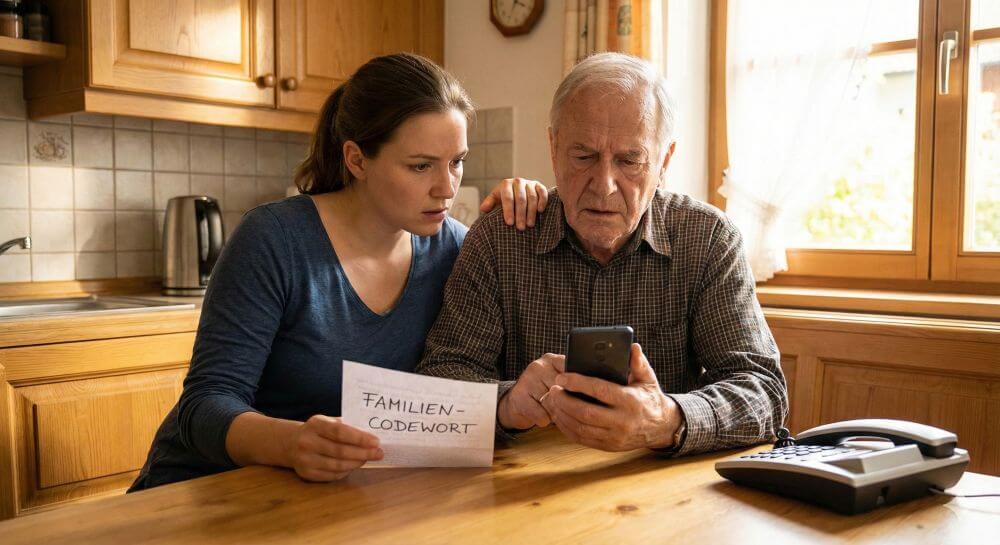

Das Familien-Codewort: Vereinbaren Sie ein sicheres Wort („Safe Word“) mit engen Angehörigen. Wenn ein Anrufer behauptet, in Not zu sein, aber das Wort nicht kennt, ist es ein Fake.

Auflegen und Rückrufen: Wenn ein angeblicher Verwandter oder Vorgesetzter mit einer unbekannten Nummer anruft und Geld fordert: Auflegen. Rufen Sie die Person unter der Ihnen bekannten, gespeicherten Nummer zurück.

Social Media Hygiene: Überprüfen Sie Ihre Privatsphäre-Einstellungen. Stellen Sie Profile auf „Privat“, sodass Fremde keinen Zugriff auf Videos mit Ihrer Stimme haben.

Skepsis bei Zahlungsaufforderungen: Seien Sie extrem misstrauisch, wenn Geld via Geschenkkarten, Kryptowährungen oder Bargeldübergabe gefordert wird.

Die sog. Demokratisierung von KI-Tools hat dazu geführt, dass hochentwickelte Cyber-Waffen nun auch gewöhnlichen Betrügern zur Verfügung stehen. Das Vertrauen in das, was wir hören, wird fundamental erschüttert. Aufklärung und veränderte Verhaltensweisen (wie das Codewort) sind aktuell die wirksamsten Verteidigungslinien gegen diese unsichtbare Bedrohung.

Quellenangaben

- McAfee Corp. The Artificial Imposter: Cybercriminals use AI cloning to scam families.

- Federal Trade Commission (FTC). Consumer Alert: Scammers use AI to enhance their family emergency schemes.

- CNN. (2023). Bericht über den Fall Jennifer DeStefano und KI-Kidnapping-Betrug.

- The Wall Street Journal. Fraudsters Used AI to Mimic CEO’s Voice in Unusual Cybercrime Case.

Suche nach:

Auch interessant:

Neueste Beiträge:

- Leica Leitzphone (2026): Der neue Maßstab für Smartphone-Fotografie?

- Amazon deckt auf: KI macht Anfänger zum Super-Hacker

- KI auf Knopfdruck weg: Das ist neu in Firefox 148

- WhatsApp Premium 2026: Kommt jetzt das Bezahl-Abo für alle?

- Kein Plagiat: Die besten KI-Tools für Studierende

- Vermeide diese 6 Fehler im Anschreiben fürs Pflichtpraktikum

Über den Autor:

Artikelsuche nach Kategorie:

Artikelsuche nach Stichwort:

Beliebte Beiträge

Individuelle Diagramme in Microsoft Excel erstellen

Michael2023-07-08T17:01:12+02:002nd, August, 2020|Kategorien: Excel, Microsoft Office, Office 365, Shorts & Tutorials|Schlagwörter: Excel, Excel Tabellen|

So erstellen Sie individuelle Diagramme in Microsoft Excel 2016/2019, und passen diese beliebig an.

Absolute Bezüge, Relative Bezüge und gemischte Bezüge Excel

Michael2025-12-07T08:02:54+01:009th, Juli, 2020|Kategorien: Excel, Microsoft Office, Office 365, Shorts & Tutorials|Schlagwörter: Excel, Excel Tabellen|

So setzen Sie relative, absolute und gemischte Bezüge in Microsoft Excel richtig ein und sparen sich viel Arbeit

Professionelle Rechnungsvorlagen in Excel erstellen

Michael2025-12-07T08:03:00+01:0015th, Mai, 2020|Kategorien: Excel, Microsoft Office, Office 365, Shorts & Tutorials|Schlagwörter: Excel, Excel Tabellen|

So erstellen Sie professionelle Rechnungsvorlagen in Microsoft Excel für Kleinunternehmer, mit Steuerausweis, Logo und allem was dazu gehört.

In 5 Schritten PowerPoint in Word einfügen

Michael Suhr2023-07-08T16:03:25+02:002nd, Mai, 2020|Kategorien: PowerPoint, Microsoft Office, Office 365, Shorts & Tutorials, Word|Schlagwörter: PowerPoint, Word|

So bringen Sie PowerPoint mit Word zusammen, und fügen bequem Präsentationen in Ihre Word Dokumente ein.

Die digitale Unterschrift in Outlook und Word

Michael2023-07-08T16:04:27+02:0019th, April, 2020|Kategorien: Outlook, Allgemein, Microsoft Office, Office 365, Shorts & Tutorials, Word|Schlagwörter: Outlook, Word|

So unterschreiben Sie mit einer digitalen Signatur in Microsoft Word und Outlook und schaffen so mehr Vertrauen beim Empfänger.

Die besten Tipps für Microsoft Word

Michael2023-07-08T16:06:07+02:002nd, April, 2020|Kategorien: Word, Homeoffice, Microsoft Office, Office 365, Shorts & Tutorials|Schlagwörter: Homeoffice, Word, Word Briefe|

Sparen Sie mit diesen Tipps für Microsoft Word viel Zeit und Nerven. Arbeiten Sie effektiver mit der beliebtesten Textverarbeitungssoftware.