Der EU AI Act und die Zukunft der Bewerbung ab 2026

Jeder, der sich in den letzten Jahren beworben hat, kennt das ungute Gefühl: Man lädt den Lebenslauf hoch und erhält binnen Sekunden eine Absage. War das ein Mensch? Oder hat ein Algorithmus entschieden, dass das Profil nicht passt?

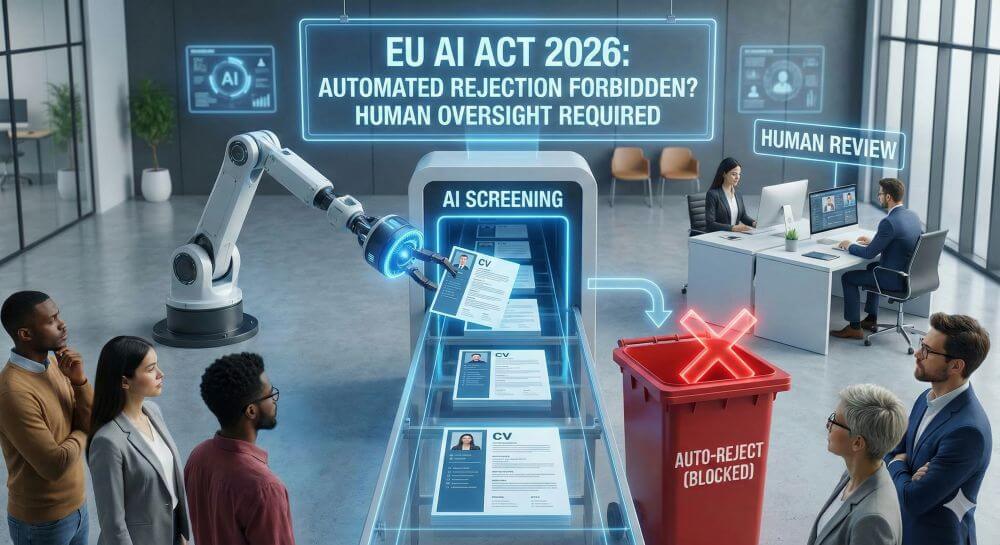

Die Nutzung von Künstlicher Intelligenz (KI) im Recruiting boomt. Doch die Europäische Union schiebt der wilden Automatisierung einen Riegel vor. Mit dem EU AI Act (KI-Verordnung), dessen volle Wirksamkeit für Hochrisiko-Systeme ab August 2026 greift, ändern sich die Spielregeln fundamental.

Doch was bedeutet das konkret? Ist das automatisierte „Aussortieren“ dann verboten? Über all das und mehr wollen wir in unserem Artikel aufklären.

Der Status Quo: Die „Black Box“ Bewerbung

Aktuell nutzen viele Unternehmen sogenannte ATS (Applicant Tracking Systems), die mit KI-Komponenten angereichert sind. Diese scannen Lebensläufe nach Keywords („Python-Kenntnisse“, „5 Jahre Erfahrung“), analysieren Sprachmuster oder bewerten sogar Video-Interviews. Das Problem: Für den Bewerber ist oft völlig intransparent, warum er abgelehnt wurde. Es fehlt an Nachvollziehbarkeit und menschlicher Kontrolle.

Ab August 2026: HR-Software als „Hochrisiko-KI“

Der AI Act teilt KI-Systeme in Risikoklassen ein. Die wichtigste Nachricht für Bewerber: KI-Systeme, die für die Einstellung, Auswahl oder Beförderung von Personal eingesetzt werden, fallen in die Kategorie „Hochrisiko“ (High-Risk).

Das bedeutet kein pauschales Verbot. KI darf weiterhin genutzt werden, um Bewerbungen zu scannen und vorzusortieren. Aber: Die Hürden für den Einsatz werden massiv erhöht. Unternehmen müssen ab August 2026 strenge Auflagen erfüllen.

1. Das Verbot der „Emotionserkennung“

Es gibt einen Bereich, in dem der AI Act tatsächlich ein Verbot ausspricht (Art. 5). Der Einsatz von KI zur Erkennung von Emotionen am Arbeitsplatz und in Bildungseinrichtungen wird untersagt (außer aus medizinischen/Sicherheitsgründen).

- Was das bedeutet: Tools, die während eines Video-Interviews dein Gesicht scannen, um zu analysieren, ob du „nervös“, „ehrlich“ oder „enthusiastisch“ wirkst, sind dann illegal. Diese pseudowissenschaftliche Praxis wird gestoppt.

2. Transparenzpflicht: Du musst es wissen

Heimliche Analysen sind vorbei. Wenn ein Hochrisiko-KI-System (z. B. ein Chatbot im Bewerbungsprozess oder ein Analysetool) mit dir interagiert, musst du darüber informiert werden (Art. 50).

- Für Bewerber: Du hast das Recht zu wissen, dass eine KI deine Daten verarbeitet und deine Eignung bewertet.

3. Menschliche Aufsicht („Human-in-the-loop“)

Das vielleicht wichtigste Element ist Artikel 14. Hochrisiko-Systeme müssen so konzipiert sein, dass sie von natürlichen Personen beaufsichtigt werden können.

- Keine autonome Absage: Die KI darf eine Empfehlung aussprechen („Kandidat passt zu 80%“), aber sie sollte rechtlich gesehen nicht die finale, unangefochtene Entscheidung über dein Schicksal treffen, ohne dass ein Mensch intervenieren kann. Der Recruiter muss in der Lage sein, die Entscheidung der KI zu verstehen und zu überstimmen.

4. Datenqualität und Diskriminierungsschutz

KI-Modelle lernen aus alten Daten. Wenn eine Firma in den letzten 10 Jahren nur Männer eingestellt hat, lernt die KI: „Männer sind gute Kandidaten“. Der AI Act verpflichtet Anbieter solcher Systeme, qualitativ hochwertige Trainingsdaten zu nutzen, um Diskriminierung (Bias) zu verhindern (Art. 10). Sortiert eine KI systematisch Frauen oder ältere Bewerber aus, drohen dem Unternehmen empfindliche Strafen.

Darf die KI mich noch aussortieren?

Jein. Hier müssen wir differenzieren:

Vorsortierung (Ranking): Ja. Die KI darf weiterhin tausende Bewerbungen scannen und sagen: „Diese 10 Kandidaten passen am besten auf die Stellenbeschreibung.“ Das spart Recruitern Zeit.

Finale Entscheidung (Rejection): Nein (nicht autonom). Eine vollautomatisierte Absage ohne jegliche menschliche Prüfung (Menschliche Aufsicht) wird rechtlich extrem riskant für Unternehmen. Es muss sichergestellt sein, dass ein Mensch die Verantwortung trägt.

Psychologische Analyse: Nein. Die Analyse von Emotionen oder das Ableiten von Persönlichkeitsmerkmalen aus Gesichtszügen ist verboten.

Wichtig: Wenn du ab August 2026 das Gefühl hast, diskriminiert worden zu sein oder dass eine KI eine Fehlentscheidung getroffen hat, stärkt der AI Act deine Rechte auf Erklärung und Beschwerde.

Der AI Act ab August 2026 ist kein Technik-Verbot, sondern ein Qualitätssicherungs-Gesetz. Die „wilde West“-Phase des KI-Recruitings endet. Bewerber werden zwar weiterhin von Algorithmen analysiert, aber sie sind nicht mehr der Willkür einer „Black Box“ ausgeliefert. Die letzte Entscheidung muss wieder in menschlicher Hand liegen.

Beliebte Beiträge

Entwicklertools in Office 365 aktivieren

Schalten Sie die Entwicklertools in Excel, Word und Outlook frei. Erweitern Sie die Möglichkeiten mit zusätzlichen Funktionen in Office 365.

Text in Word diktieren und schreiben lassen

Texte in Word zu diktieren ist erheblich leichter und geht flotter als wenn Sie alles über die Tastatur eingeben müssen. Spracherkennung in Word funktioniert genauso wie externe Spracherkennungssoftware.

Die 10 wichtigsten Formeln und Funktionen in Excel

Wenn Sie Schreibtischtäter sind, dann müssen Sie zwar nicht zwingend ein Excel-Experte sein, aber es gibt ein paar Funktionen in Excel die Sie auf jeden Fall kennen sollten. Wir haben die 10 wichtigsten zusammengefasst.

Kopfzeile und Fusszeile in Word – Erste Seite anders in Word

So erstellen Sie Kopfzeilen auf der ersten Seite anders als auf den restlichen Seiten. Erstellen Sie auch eigene Fußzeilen in Word für Ihre Dokumente.

Excel Tabellen bereinigen

Ohne System erstellte Excel Tabellen vorgesetzt zu bekommen, und daraus trotzdem verwertbare Daten zu gewinnen geht mit ein paar Tricks ganz leicht.

Der Szenario Manager und die Zielwertsuche in Excel

Wie Sie in Microsoft Excel den Szenario Manager und die Zielwertsuche einsetzen können, um komplexe Sachverhalte platzsparend und übersichtlich darzustellen.